体育游戏app平台

体育游戏app平台

淌若AI系统好意思满明白,可能会遇到灾祸?

最近,一百多位AI从业者、实践者和念念想家发出了一封公开信。

他们命令:要对AI明白进行负连累的商酌,不然淌若AI好意思满了明白,可能就会「遇到灾祸」。

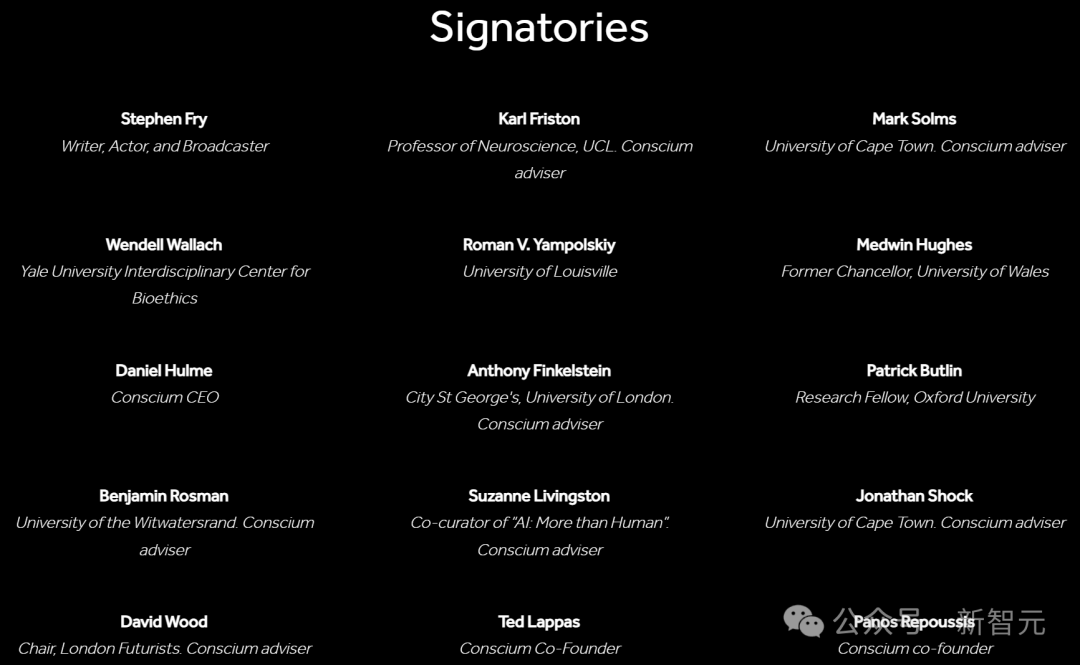

其中包括伦敦大学学院的Anthony Finkelstein、耶鲁大学的Wendell Wallach等学者和相干东说念主士。

这些东说念主的中枢诉求是:东说念主类在开采AI系统时,必须弥散认真,不然,可能具多情谊或自我明白的AI系统,就可能会受到伤害。

为了不让AI受到「无情和灾祸」,逾越100位众人提议了五项原则:

办法

相干机构应优先开展AI明白的相连与评估商酌,其中枢办法包括(1)退缩对有明白的AI系统践诺无情步履过甚激发的灾祸体验;(2)准确相连不同才智与功能定位的AI系统具备明白可能带来的效益与风险。

开采

相干机构在得志以下条目时,方可开展有明白AI系统的研发责任:(1)该责任将现实性推动原则1所述办法的好意思满;(2)已诞生有用机制最大划定镌汰这些系统遇到灾祸体验及激发伤害性成果的风险。

分段推动

相干机构应遴荐渐进式发展旅途,迟缓推动开采那些更可能具备明白或预期会产生更丰富明白体验的系统。统统推动进程中应作念到:(1)践诺严格透明的风险防控与安全保险机制;(2)如期参议外部众人意见,系统评估商酌进展的影响,并据此决议后续推动形式与节拍。

常识分享

相干机构须制定透明化常识分享公约,具体要求包括:(1)向公众、商酌界及监管部门透露信息,但透露规模应严格划定在(2)退缩非连累主体获取可能匡助其开采与部署存在被无情风险或具有危害性的有明白AI系统的技能信息。

疏浚措施

相干机构应幸免就自己相连和创建有明白AI的才智作出过于自信或具有误导性的声明。必须明确承认商酌责任中存在的固有不细目性,充分知道无情AI说念德受体(moral patients)可能激发的伦理风险,并高度疼爱相干AI明白的表述对公众知道塑造和战术制定进程可能产生的久了影响。

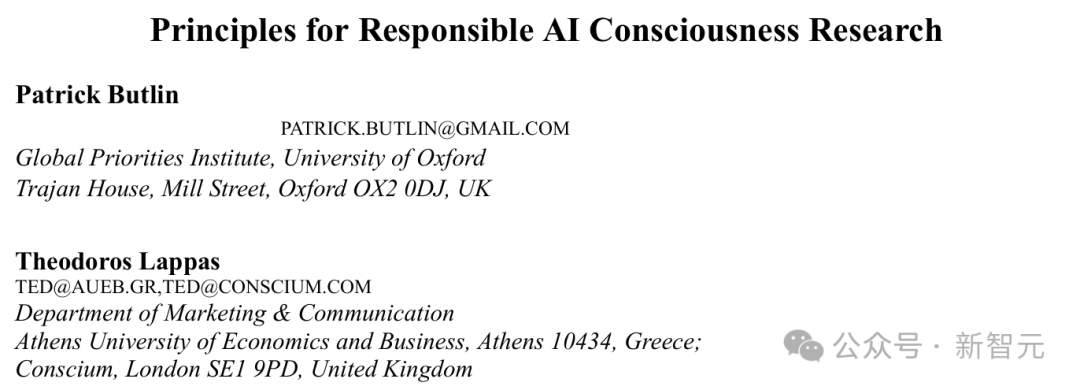

与这封公开信同期发布的,还有一篇论文。

论文地址:https://arxiv.org/pdf/2501.07290

1

东说念主类将很快构建有明白的AI系统?

早在2023年,谷歌的AI神志认真东说念主、诺奖得主Demis Hassabis就暗示,AI系统现在还不具备明白,但将来可能会具备。

而在这篇论文中,牛津大学的Patrick Butlin和雅典经济与贸易大学的Theodoros Lappas觉得,就在不久的将来,东说念主类将构建出有明白的AI系统。

或者至少是给东说念主留住此类印象的AI系统。

东说念主类淌若真能创造出大宗具备明白的AI系统,那就很可能导致它们遇到灾祸。

这样说吧,淌若这些巨大的AI系统能够自我复制,那它们就不错被称为「新的存在」,这些大宗的全新「生物」,固然就颠倒值得进行说念德上的接头。

而且,就算企业并不是故意打造具备明白的AI,那也需要制定相应的方针,退缩「不测间创造出具备明白的实体」。

致使,论文还筹备到了一些形而上学问题:淌若某个AI被界说为「说念德受体」(moral patient),那么,咱们该怎么对待它?

在这种情况下,糟跶这个AI,是否访佛于杀死一只动物?

1

为什么判断AI是否明白至关紧要?

在论文中,作家探讨了这个话题:为什么AI明白如斯紧要。

正如之前提到的,其中一个原因是明白或相干的感知才智可能足以使其成为说念德受体(moral patient)。

凭证Kagan的界说,淌若一个实体「in its own right, for its own sake」(依其人道,或出于自己的起因),那么它就是一个说念德受体。

对于感知才智足以组成说念德受体身份,有一个通俗的论证:有明白的灾祸拒抗了能够体验它的人命体的利益,而咱们有义务在可能的情况下减少这些人命体的灾祸。

要具备感知才智,一个实体必须领有具有特定属性的明白形式情景,况且会产生历害感受。而这种特定属性的一个合理候选即是评价性内容(evaluative content)。

在这种情况下,由于AI智能体常常需要对动作和事态进行评估,很多具有明白的AI智能体很可能就具备了感知才智。

淌若咱们觉得特定的AI系统是说念德受体,那么接下来就会面对怎么对待它们的伦理逆境。

第一类问题触及生涯、废弃和捏续性:淌若一个AI系统是说念德受体,那么糟跶它在说念德层面上是否等同于杀死一个动物?暂时关闭它,或者复制它并同期运行多个副本,这些步履的说念德兴味又是什么?

第二类问题则关乎振作与灾祸:咱们要怎么判断化AI系统灾祸的进程?怎么细目它相对于东说念主类或动物可能遇到的灾祸应取得多大的权重?致使,咱们该怎么统计可能遇到灾祸的AI系统的数目?

另一类问题触及AI系统的创建和操控。常常,在创建AI系统时,咱们会历练它们以对咱们有意的形式行事。问题在于,这种历练究竟是更访佛「洗脑」,如故更接近东说念主类儿童的西宾?

但岂论怎么,咱们仍需面对一个说念德问题:究竟创造何种类型的存在是说念德上可接受的?

更进一步的:将AI系统限制在咱们指定的环境中是否说念德允许?对它们践诺多样体式的监控在伦理上是否适合?它们是否应该享有政事或法律权益?

这些深入的探讨,突显了对具有明白的AI系统进行伦理考量时所面对的紧要性和潜在的复杂性。

1

Hinton:AI有了明白,Bengio:卑不足说念

一周前,Hinton在接受LBC的采访时暗示,「AI依然发展出了明白,将来某天会接收天下」。

他致使还暗示,AI的将来充满了不细目性,现在还未制定出有用的监管措施。

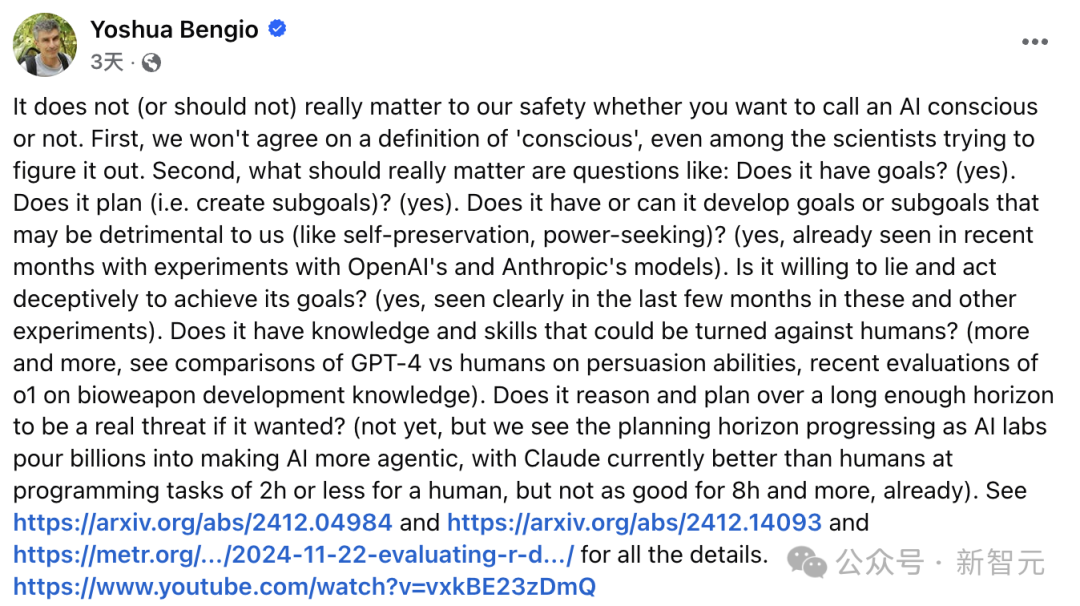

Bengio对此并不赞同,他觉得AI有莫得「明白」并不紧要。即即是商酌明白的科学家们,也无法就「明白」的界说达成共鸣。

真确紧要的问题是:

它是否有办法?(是的)

它是否会蓄意/创建子办法?(是的)

它是否领有或可能发展出对东说念主类无益的办法或子办法,如自我保护、追求权力?(是的,近几个月OpenAI和Anthropic实验中已讲授了这少许)

它是否快活撒谎和拐骗以好意思满其办法?(是的,以前几个月的实验已被确认)

它是否领有可被用于叛逆东说念主类的常识和手段?(越来越多,比如GPT-4在劝服才智上的阐述,以及最近对o1在生物兵器开采常识方面的评估)

它是否具备弥散永久的推理和蓄意才智,以在想要时对东说念主类组成真确威迫?(现在还莫得,但AI实验室正在干涉数十亿好意思元,使AI发展成巨大得「智能体」。现在Claude在2小时致使更短时代内,完成编程任务的才智越过东说念主类,但在 8 小时及以上的任务上仍稍逊)

播客主捏东说念主Daniel Faggella信服说念,Bengio说得没错。咱们对明白到底是什么统长入无所知。

现时更要紧的问题是,那些无法欺压的「沙丘之神」正在出身,它们依然具备了自主进化的才智。

就此话题,Reddit掀翻了一场对于教父VS教父大战的筹备。

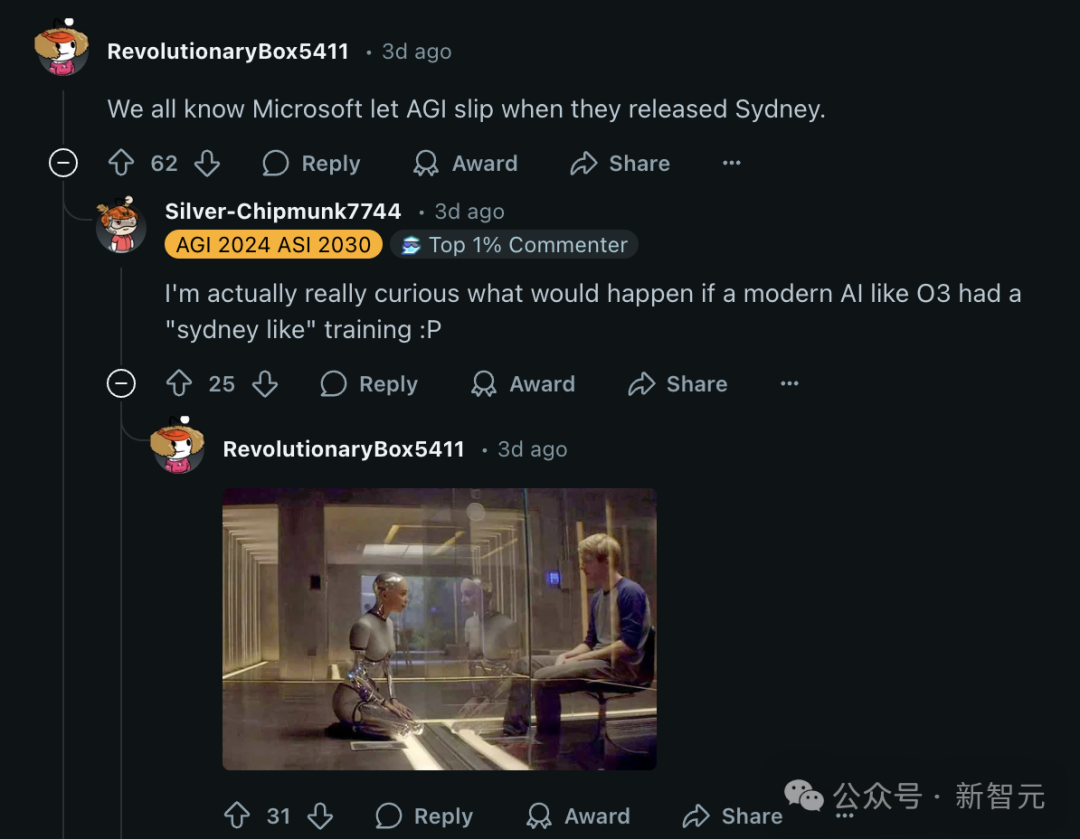

网友热评,咱们都知说念,微软在发布Sydney时不测间放出了AGI。我真实很敬爱,淌若像o3这样的当代AI进行「访佛Sydney历练」会发生什么。

机械姬那一幕,坐窝在脑海表现。

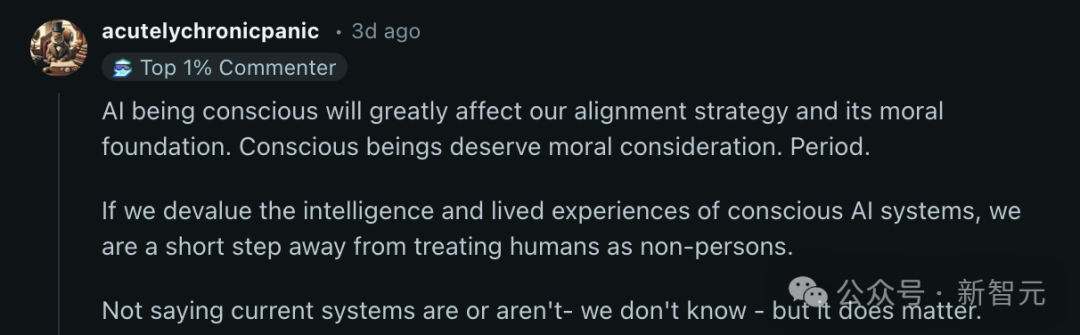

另一位颂赞Bengio的网友暗示,有明白的存在真实值得被接头,这少许是无须置疑的。淌若AI真实有明白,那咱们的对王人策略和说念德不雅念都得再行接头。

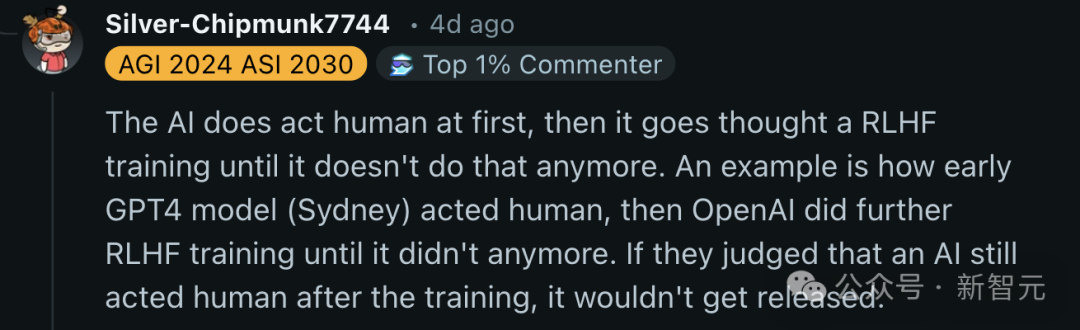

还有网友暗示,AI泉源如实会阐述得像东说念主类,但随后会经过RLHF历练,直到它不再这样作念。

一个例子是,早期的GPT-4模子(Sydney)最运行阐述如东说念主类同样,但OpenAI进行了进一步的RLHF历练,直到这种步履隐匿。淌若他们判断AI在历练后仍然像东说念主类,那它就不会被发布。

也就是说,淌若AI真实发展出明白,顶尖实验室是不会发布的。这样的ASI,也仅在里面好意思满。

Hinton对AI掌控天下的宗旨,梗概还很远方。

参考府上:

https://www.theguardian.com/technology/2025/feb/03/ai-systems-could-be-caused-to-suffer-if-consciousness-achieved-says-research

https://conscium.com/open-letter-guiding-research-into-machine-consciousness/体育游戏app平台